Large-Vocab 음성인식을 위한 문맥의존적 사전학습 심층 신경망 - 음성인식에서 딥러닝이 고전 모델을 이긴 첫 사례

- 기존에 잘 작동하는 모델들(특히 CD-GMM-HMM)은 적은 수의 레이어만을 가지고 있었기 때문에 역전파 알고리즘과 오토인코더 학습만으로 좋은 결과를 얻을 수 없었기에 실제 사용에 있어서 ASR(Automatic Speech Recognition)의 성능은 인간 수준에 미치지 못했다.

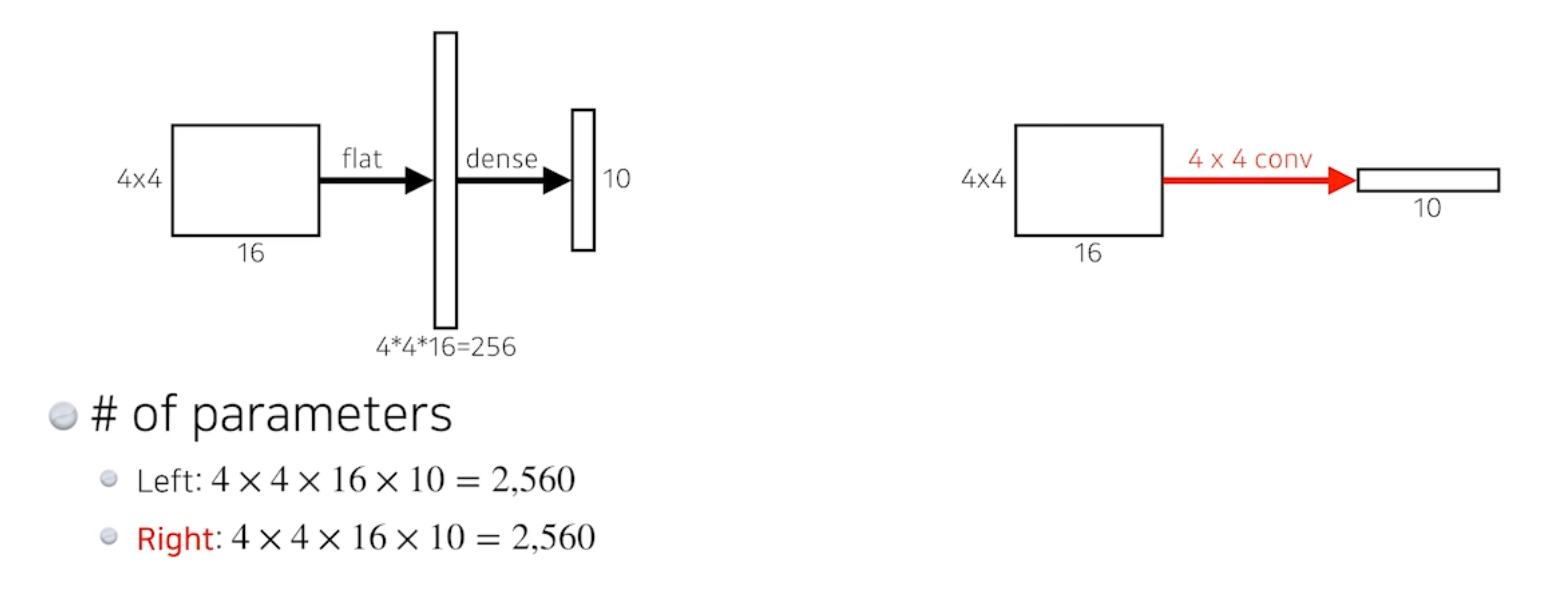

- CD-DNN-HMM은 CD-GMM-HMM에서 HMM구조와 심층신경망을 결합한 형태로, 비지도학습 방식의 사전학습 HMM 모델의 정답을 DNN의 Training Label로 활용하는 준지도학습 방식의 딥러닝모델이다. 사전학습 때에는 심층 신뢰망(BDN)을 모방하여 오토인코더로 비선형적인 패턴을 학습하며 이후에는 BDN의 구조를 버리고 라벨링된 데이터를 가지고 Fine-Tuning을 진행하며 학습을 진행한다.

- 적은 데이터만으로도 적은 Training Error를 기록하며 CD-GNN-HMM보다 훨씬 나은 성능을 입증했으며 딥러닝 모델로 시퀀셜한 데이터를 정교하게 학습할 수 있음을 입증했다.

어떤 문제가 있는지, 그 문제를 풀기위한 기존의방법, 기존 방법의 한계와 이 논문의 방법은 어떻게 문제를 해결했는지

Abstract

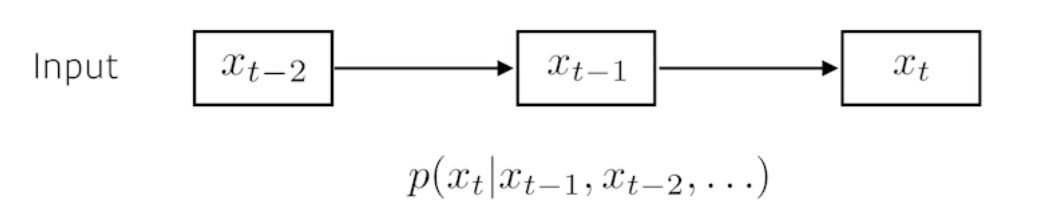

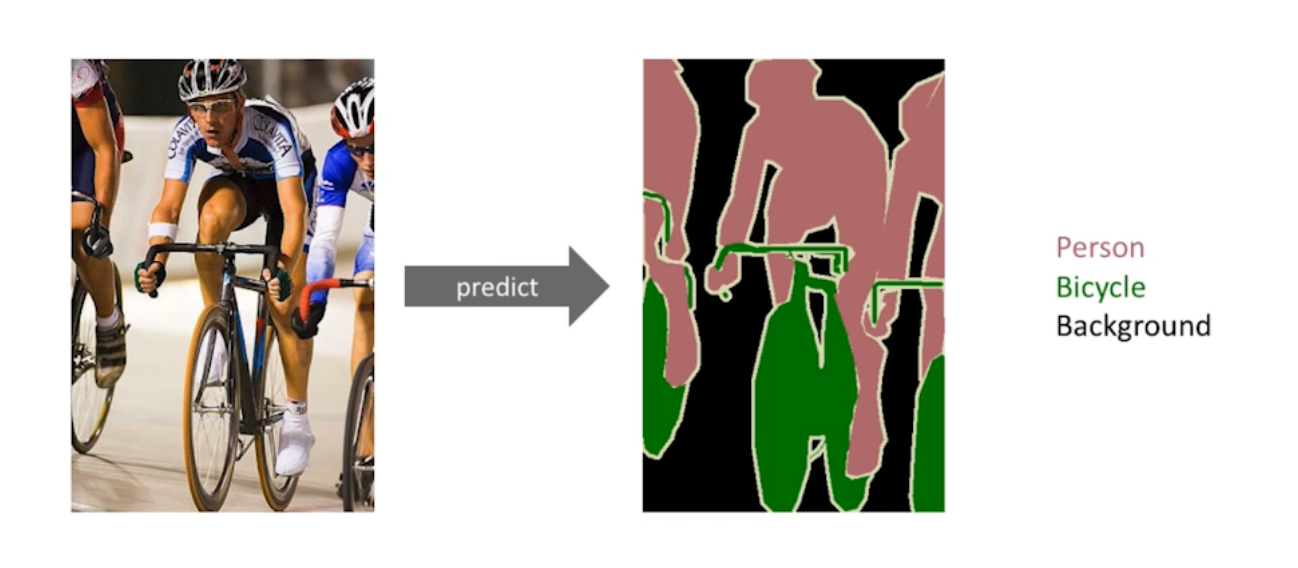

해당 논문에서는 대규모 단어집합의 음성인식(LVSR)을 위해 새로운 CD(Context-Dependent) 모델을 제안한다. 해당 모델은 DNN-HMM(Deep Neural Network - Hidden Markov Model) 구조로 되어있고, Senone(음성 인식의 term)의 분포를 출력하도록 훈련한다. 또한 CD-DNN-HMM을 LVSR에 적용하는 절차를 설명하고 고전적인 GMM-HMM(Gaussian Mixture Model) 구조의 성능을 크게 능가하는 것을 입증한다.

Introduction

최근 MMI(Maximum Mutual Information) Estimation, MCE(Minimum Classification Error) Training, MPE(Minimum Phone Error) Training, large-margin techniques, HMM(Hidden Markov Model), CRF(Conditional Random Fields, 새로운 음향모델) 등 주목할만한 발전이 있었지만, 그럼에도 불구하고 실제 사용에 있어서 ASR(Automatic Speech Recognition)의 성능은 인간 수준에 미치지 못했다.

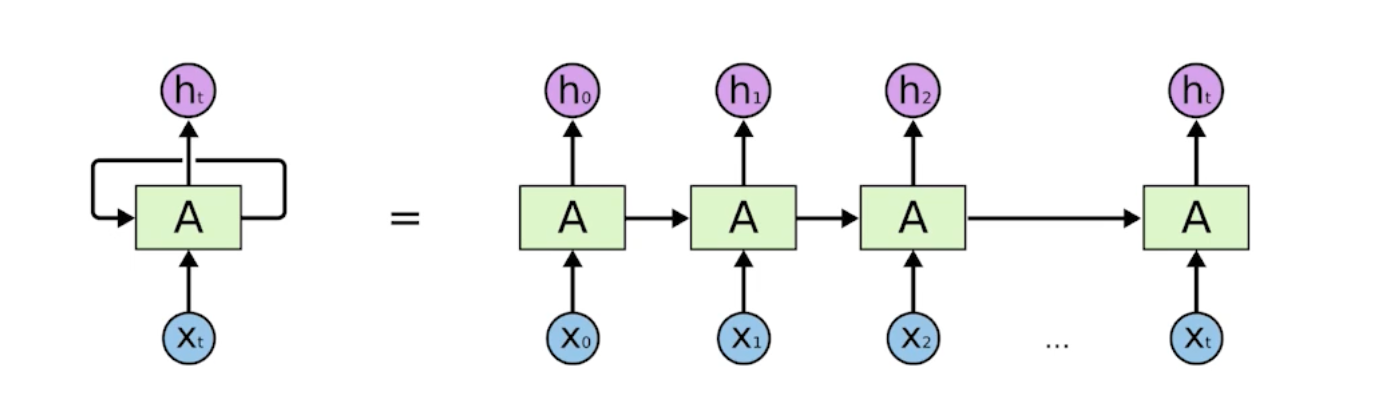

최근 촘촘하게 직결되어 있고 많은 hidden layer를 가진 신뢰망(Belief Nets)에 주요한 발전이 있었다. 그 결과 심층신뢰망은 데이터에서 복잡한 통계적 패턴을 포착할 수 있는 비선형적인 특징 검출기의 계층을 학습할 수 있었다. 심층신뢰망의 학습 알고리즘은 우선 각각 레이어의 가중치를 순전히 비지도(unsupervised)적인 방법으로 개별적으로 초기화하고 라벨링된 데이터로 전체 네트워크를 미세조정한다. 이러한 준지도(semi-supervised)적인 접근은 음성, 오디오, 텍스트, 이미지 데이터의 분류 등을 포함한 수많은 어플리케이션에 효과적이라는 것이 입증되었다. 이러한 발전은 사전학습된 신경망과 ASR을 위한 다른 딥러닝 테크닉들을 기반으로 한 음향모델(acoustic model) 개발에 흥미를 불러일으켰다. 예를들어 문맥독립적인 사전학습된 심층신경망 HMM 하이브리드 구조는 최근에 전화인식 분야에 제안되었고 매우 경쟁력있는 성능을 달성했다. 심층신경망의 가중치를 초기활 때 사전학습을 사용하는 것은 문헌에서 논의된 두 가지의 잠재적인 이점이 있다. 사전훈련은 테스트케이스가 반복되지 않을 정도로 방대한 데이터셋이 있을 때에도 더 많은 데이터에 대해 일반화의 오류가 줄어들지 않는 효과를 가진 데이터 의존적인 독특한 종류의 정규화 방식으로 보자는 근거가 제시되었다. 입력들의 분포에 대한 정보를 사용함으로써 정규화를 통해 비교적 적은 라벨링 데이터로도 매우 표현력이 뛰어난 모델을 학습시킬 수 있다. 또한 다른이들도 추후의 최적화(전통적으로 SGD)를 목적으로 한 사전훈련과 일치한다는 증거를 보고했다. 결론적으로 사전훈련된 신경망은 사전훈련되지 않은 신경망보다 낮은 training error를 달성한다. 이러한 효과는 특히 깊은 오토인코더에서 두드러진다.

심층신뢰망은 최초의 사전훈련방식으로 연구된 방법이다. 깊은 오토인코더들이 사전훈련 심층신뢰망으로 효율적으로 학습될 수 있다는 것이 밝혀지고, 더 깊은 신경망에 대한 관심이 되살아났다. 많은 연구자들 역시 사전훈련이 많은 문제들과 모델 아키텍쳐, 심지어 거대한 데이터셋으로 훈련된 하나의 싱글레이어를 가진 신경망의 경우에도 도움이 될 것이라고 보고했다. 우리는 비지도학습 방식의 사전훈련 테크닉들을 많은 히든 레이어를 가진 신경망을 학습하는데 편리하고 강력한 방법이라고 보았다.

이러한 경유로 본 논문에서는 사전훈련된 심층신경망(DNN)과 문맥의존적(CD) 히든 마르코프 모델 사이의 하이브리드 구조인 새로운 음향모델을 제안한다. 본 모델에 사용된 사전학습 알고리즘은 심층신뢰망(DBN)이지만, dynamic Bayes net과 구별하고, 사전훈련이 끝난 후에 심층신뢰망을 버리고 오직 인식가중치를 유지하고 훈련하는 것과 구별하기위해 DNN-HMM이란 용어로 축약할 것이다. CD-DNN-HMM은 심층신경망의 힘과 CD-HMM의 시퀀셜한 모델링 능력을 결합한다. 즉, 모델의 주요 요소를 설명하고 파라미터를 학습하는 과정을 설명하며 CD-GMM-HMM의 성능을 뛰어넘는 것을 입증할 것이다.